1. Spark 설치

1. Spark 설치 파일 다운로드

wget https://archive.apache.org/dist/spark/spark-3.2.4/spark-3.2.4-bin-hadoop3.2.tgz

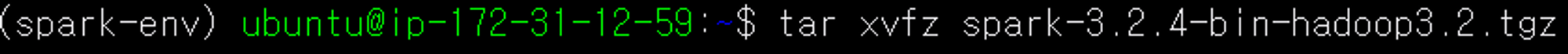

2. Spark 설치 파일 압축풀기

tar xvfz spark-3.2.4-bin-hadoop3.2.tgz

3. 폴더명 수정하기

mv spark-3.2.4-bin-hadoop3.2/ spark-3.2.4/

2. Spark 환경 변수 편집하기

vim ~/.bashrc 명령어로 bashrc 파일을 연다.

다음과 같이 스파크 환경 변수를 설정한다.

# SPARK

export SPARK_HOME=/path/to/spark-3.2.4

export PATH=$PATH:$SPARK_HOME/bin

3. Spark 실행하기

Spark는 Hadoop없이도 작동이 가능하기 때문에 spark-shell 또는 pyspark 명령어를 이용하여 스파크 쉘이 잘 뜨는지 확인하면 된다. Spark는 스칼라라는 언어로 개발되어 있다.

참고로 spark-shell 은 스칼라 언어로, pyspark 는 파이썬 언어로 드라이버 프로그램을 만들 때 사용할 수 있다.

빠져 나오기는 ctrl + d

4. pyspark 설치하기

spark를 파이썬으로 사용할 수 있는 pyspark를 설치한다.

기존에 설치한 spark 버전이 spark-3.2.4이므로 호환하는데 문제가 발생하지 않게

스파크 버전에 맞춰 pyspark도 3.2.4버전으로 설치해야 한다.

pip install pyspark==3.2.4

pyspark 명령어로 pyspark를 실행할 수 있다.

5. Spark Web UI 주소 변경하기

Spark Web UI도 어디서든 접속 가능하게 하기 위해 우선 spark-defaults.conf.template 파일을 복사한다.

cp $SPARK_HOME/conf/spark-defaults.conf.template $SPARK_HOME/conf/spark-defaults.conf

복사한 파일을 열고 다음과 같이 입력한다.

vim $SPARK_HOME/conf/spark-defaults.confspark.driver.host 0.0.0.0

6. 파이썬 경로 수정하기

사용 중인 가상환경(spark-env)의 파이썬 경로를 복사한다.

spark-env.sh를 열어 사용 중인 가상환경의 파이썬으로 경로를 수정한다.

7. Spark 사용하기

'Cloud > AWS' 카테고리의 다른 글

| [AWS] 실시간 영상 스트리밍: 맥북 웹캠과 AWS Kinesis Video Streams 연동 (1) | 2024.12.20 |

|---|---|

| [AWS] Visual Studio Code에 EC2 연결하기 (0) | 2024.07.06 |

| [AWS] EC2 서버에 Python 개발 환경 구축 _ Miniconda, Jupyter Notebook (0) | 2024.06.25 |

| [AWS] EC2 서버에 MySQL 환경 세팅 및 Workbench 연결 (0) | 2024.05.28 |

| [AWS] EC2 인스턴스 생성 후 로컬에서 SSH로 접속하기 (0) | 2024.05.28 |